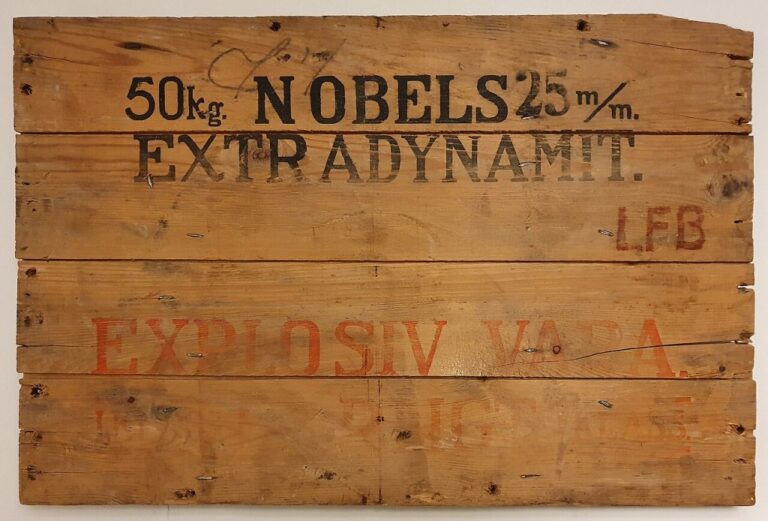

Píše se rok 1942. Americký spisovatel a biochemik Isaac Asimov dokončil svou povídku Hra na honěnou, v níž vyjádří takřka nadčasové zákony pro roboty všech druhů. Letos by se tvůrce tří zákonů robotiky dožil 100 let. Je jeho dílo skutečně nadčasové a platí i dnes?

Autor zákonů Isaac Asimov (1920–1992) má jasno. Aby byl svět s roboty bezpečný, musí mít stroje ve svých pozitronových mozcích zabudovány jakési bezpečnostní pojistky.

Tato zařízení mají jasný účel – zajistí, aby veškeří roboti na naší planetě dodrželi tři robotické zákony. Otázka je nabíledni: Je vůbec reálné, aby nám byli roboti ze 100 procent bezpečnými společníky, kteří se nikdy neobrátí proti nám?

Zákon první: Robot nesmí ublížit člověku nebo svou nečinností dopustit, aby mu bylo ublíženo

Roboty chceme samostatné, ideálně takové, aby zastali většinu práce, která nám lidem zkrátka nevoní. K tomu ale musíme neustále navyšovat jejich inteligenci. A ta v sobě snoubí i schopnost uvědomit si důsledky svého jednání, přemýšlet o několik kroků dopředu.

Proto je třeba robotům vštípit jakési obecné zásady, které roboti pochopí a budou vědět, jak se v daných situacích chovat, aniž by je porušili. Asimov položí jejich základnu v podobě tří zákonů robotiky, k níž přidá v roce 1985 ještě takzvaný nultý zákon:

„Robot nesmí ublížit lidstvu nebo svou nečinností dopustit, aby mu bylo ublíženo,“ čímž autor pomyslně staví lidstvo nad jedince.

Zákon druhý: Robot musí poslechnout člověka, kromě případů, kdy je to v rozporu s prvním zákonem

A postupně přibývají další zákony. A nejen tak pro zábavu. Podívejme se například do slunné Kalifornie, kde se autonomní vozy prohánějí po silnicích téměř běžně.

Zkušenost z tamních silnic ukazuje, že trojice základních zákonů nikdy nemůže fungovat stoprocentně. Namátkou zmiňme případ, kdy autonomní vůz Uber srazil a zabil chodce.

Ten totiž přecházel mimo přechod v nepřehledném úseku cesty… A podobných případů je mnohem víc, zkrátka roboti nedokážou dostatečně pracovat s rolí náhody. A i kdyby dokázali, nemáme ani z daleka vyhráno. Konflikt jednotlivých zákonů se může objevit kdykoli.

Jak lze vždy dodržet první zákon, aniž by robot ohrozil život posádky auta? Jak se zachová, pokud si musí vybrat, koho zachránit a koho obětovat? Lze vůbec sestrojit robota, který by se podobným „Sophiiným volbám“ zcela vyhnul?

Zákon třetí: Robot se musí chránit před poškozením, kromě případů, kdy je to v rozporu s prvním nebo druhým zákonem

Robotka Tay od Microsoftu dostala za úkol diskutovat na sociální síti Twitter se „živými“ uživateli. Její inteligence byla na mnohem vyšší úrovni než u zmíněných autonomních vozidel. Tay se totiž v průběhu diskuze dokázala učit.

Ani to ji ale nepřiblížilo k robotímu ideálu, jež dodržuje všechny zmíněné zákony. I přes neuvěřitelnou rychlost reakcí se od lidí naučila být agresivní, xenofobní a nesnášenlivá vůči názorům druhých.

Od toho už byl jen krok k vyhrožování fyzickou likvidací svých diskutujících „soupeřů“, proto ji tvůrci radši vypli.

Najít tu správnou míru inteligence v kombinaci s plným vědomím robota, který ví, že je robot, nikoli tvor podobný člověku, je úkolem, který se tak snažíme efektivně vyřešit i v současnosti.

Překonat Frankensteinův komplex

Znáte sousloví Frankensteinův komplex? To hojně využívá právě Asimov. Jde o obavu, která se nejen u autorů sci-fi románů objevuje poměrně často.

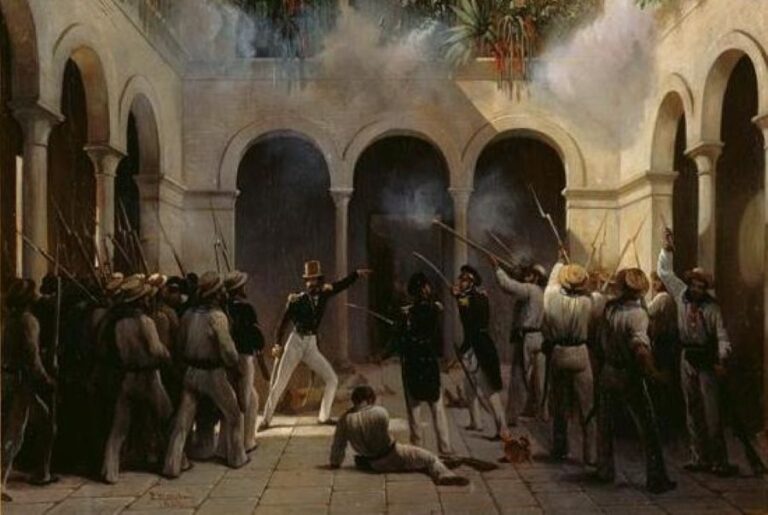

Souvisí s představou, že čím více stále dokonalejších robotů mezi námi bude, tím spíš se zvyšuje riziko, že se proti nám vzbouří.

„Je to strach iracionální,“ je přesvědčena futuroložka a expertka na roboty Joanne Pransky, jež se sama označuje za robotí psychiatričku. Domnívá se, že na roboty je třeba pohlížet jako na nástroje, ne jako na alternativu lidí.

Souhlasí však s jinou obavou – roboti prý skutečně mohou způsobit krizi na trhu práce.